Don't Miss

跑贏輝達?|美企AI新方案號稱快輝達20倍

By 信報財經新聞 on August 29, 2024

原文刊於信報財經新聞「EJ Tech 創科鬥室」

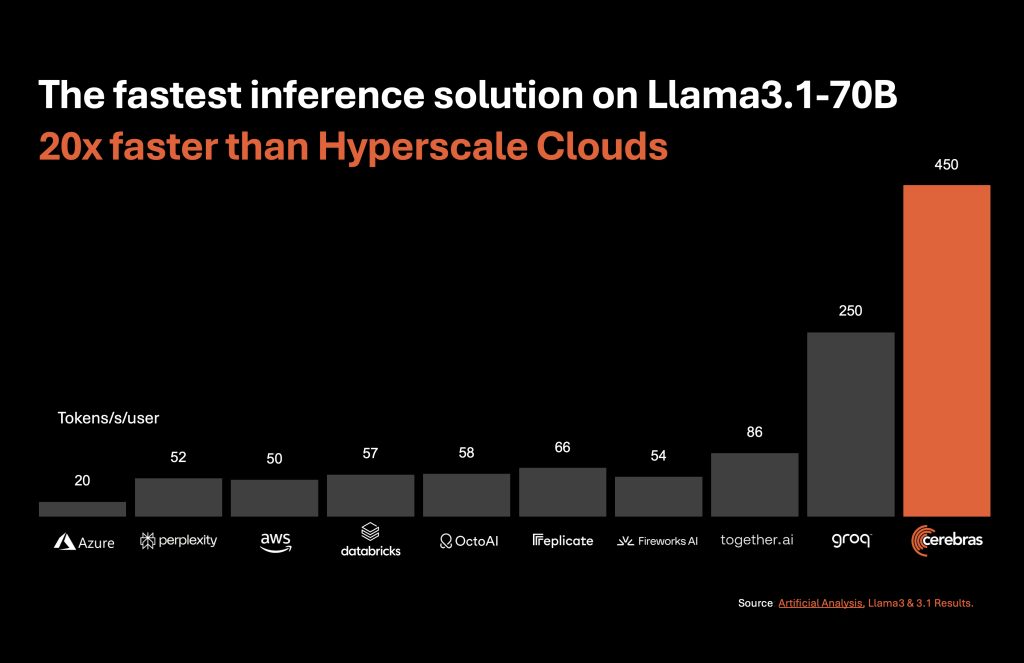

美企Cerebras Systems周二(27日)推出號稱是全球最快的AI解決方案Cerebras Inference。模型輸出速度方面,Llama 3.1-8B為每秒1800個Tokens,而Llama 3.1-70B為每秒450個Tokens,據稱比輝達(Nvidia)繪圖處理器(GPU)為基礎的超大規模雲端快20倍,以「高速推理」挑戰後者的市場領導地位。

Cerebras成本耗電量較H100低

Cerebras Inference由美國4個數據中心支持運算,當中採用第三代晶圓級引擎WSE-3,成本及耗電量只是輝達H100的兩成。新方案透過應用程式介面(API),向任何已登入用戶免費開放;針對開發人員的版本,以Llama 3.1-8B模型為例,每百萬Tokens收費10美仙(約0.78港元);規模較大的Llama-3.1 70B模型,每百萬Tokens收費60美仙(約4.68港元)。

外媒The Information報道,美企OpenAI準備推出一款具備先進功能的新AI產品,模型在內部被稱為「士多啤梨」或Q*(發音為Q-Star),以應付目前AI模型無法解決的問題及任務。話說OpenAI行政總裁阿爾特曼(Sam Altman)本月初在社媒X張貼一張「士多啤梨」盆栽相片,惹來網民揣測箇中玄機。

支持EJ Tech

如欲投稿、報料,發布新聞稿或採訪通知,按這裏聯絡我們。

如欲投稿、報料,發布新聞稿或採訪通知,按這裏聯絡我們。